KI – Mensch – Atomwaffen

Die Menschen auf dem Laufenden zu halten, reicht nicht aus, um die KI für Atomwaffen sicher zu machen

meint Peter Rautenbach am 16. Februar 2023 auf der Website der Nuclear Scients

Foto: US Navy

Die leistungsstarken Computer des Aegis-Kampfsystems seien in der Lage, feindliche Ziele zu verfolgen und autonom zu entscheiden, ob sie zerstört werden sollen. Auf diesem Foto startet ein Zerstörer der Aegis-Klasse eine seiner eigenen Raketen, um während einer Übung im Jahr 2009 eine andere Rakete abzufangen.

Systeme der künstlichen Intelligenz (KI) leiden aber wie wir wissen unter einer Vielzahl einzigartiger technischer Probleme, die das Risiko eines unbeabsichtigten Einsatzes von Atomwaffen stark erhöhen könnten, so Rautenbach. Um diese Probleme in den Griff zu bekommen, hätten sich die Vereinigten Staaten und das Vereinigte Königreich dazu verpflichtet, Menschen in den Entscheidungsprozess einzubeziehen. Die größte Gefahr liege jedoch möglicherweise nicht in der Technologie selbst, sondern in ihrer Auswirkung auf den Menschen, der mit ihr interagiert, so Rautenbach.

m

m

Menschen auf dem Laufenden zu halten, reiche nicht aus, um KI-Systeme sicher zu machen. Tatsächlich könne das Vertrauen auf diesen Schutz zu einer versteckten Erhöhung des Risikos führen. Wenn man wie ich beim Robotics Day der FH Technikum Expertenvorträge zur KI von Amazon und ihren teilweise äußerst „unintelligenten“ Vorschlägen hört oder mit ChatGPT exerperimentiert, dann scheint nackte Angst dass uns ein AI-Fehler auslöscht mehr als angebracht. Die Systeme müssen so rasch wie möglich global verboten werden.

Deep Learning – Tiefes Lernen. Automatisierung verleiht Maschinensystemen die Befugnis, an der Seite des Menschen oder an seiner Stelle zu agieren. In unterschiedlichem Maße hat die Automatisierung seit den Anfängen der Atomwaffen eine Rolle in Abschreckungs- und Befehls- und Kontrollsystemen gespielt, aber fortschrittliche KI würde die Automatisierung auf die nächste Stufe heben, so Rautenbach.

KI – Systeme sind zwar heute gelegentlich oft in der Lage, Probleme zu lösen oder Funktionen auszuführen , für die traditionell menschliches Wissen erforderlich war. Maschinelles Lernen, eine Teilmenge der KI, ist der übergreifende Treiber hinter dem aktuellen Anstieg intelligenter Maschinen. Deep Learning, ein fortschrittlicher maschineller Lernprozess, verwendet Schichten künstlicher neuronaler Netze, um Muster zu erkennen und große Mengen unstrukturierter oder unbeschrifteter Daten zu bewerten und zu verwalten.

Diese Fähigkeit habe es ermöglicht, fahrerlose Autos, virtuelle Assistenten und Betrugserkennungsdienste zu entwickeln. Wobei heute noch heftige Haftungsfragen beim versagen ungeklärt sind. Nach KI-Irrtum mit Atomwaffen wäre die Erde wohl auch für Rechtspersonal unbewohnbar.

Während kein Staat offen versucht, seine Atomwaffensysteme vollständig zu automatisieren, scheine die Integration von KI in Kommandosysteme vielversprechend und sogar unvermeidlich, so Rautenbach. KI könne Frühwarnsysteme ergänzen, strategische analytische Unterstützung und Bewertung bieten, Kommunikationssysteme stärken und eine Form der Vorhersage ähnlich der prädiktiven Polizeiarbeit bereitstellen. Wobei letzere mit guten Gründen nicht KI überlassen werden sollte, wie Katharina Zweig in ihrem Standardwerk zum Thema deutlich darlegte. Rautenbach meint: die KI-Integration birgt sowohl potenzielle Risiken als auch Vorteile. Er zählt die guten, schlechten und hässlichen Seiten dieser sich schnell entwickelnden Technologie auf:

„Das gute“. Die Integration von KI in Führungssysteme biete verlockende strategische Vorteile für Staaten. KI-Systeme könnten ihre zugewiesenen Funktionen mit atemberaubender Geschwindigkeit ausführen und menschliche Bediener drastisch übertreffen, ohne Ermüdung oder nachlassende Genauigkeit zu erfahren. Sie können enorme Datenmengen durchsuchen, um Muster und Verbindungen zwischen scheinbar nicht zusammenhängenden Datenpunkten zu finden.

„KI könnte auch Abschreckungssysteme sicherer machen“. Menschen hätten Schwächen und machen Fehler. Die Automatisierung könnte die Anzahl der nuklearen Notrufe reduzieren, die mit menschlichem Versagen, kognitiver Verzerrung und Ermüdung zusammenhängen. Darüber hinaus könne KI Unsicherheiten reduzieren und die Entscheidungsfindung verbessern, indem sie die Kommunikation schütze und die Zeit verlängere, die Entscheidungsträgern zur Verfügung stehe, um auf angebliche Starterkennungen zu reagieren.

Öffentliche Äußerungen von Beamt*innen wie dem ehemaligen General des US-Strategischen Kommandos, John Hyten, und der ehemaligen Direktorin des Nuclear Command, Control, and Communications Enterprise Center des US-Strategischen Kommandos, Elizabeth Durham-Ruiz, untermauern die Bedeutung, die KI in naher Zukunft in nuklearen Kommandosystemen spielen könnte. Diese Unterstützung der KI-Integration in das Nuklearkommando geschehe gleichzeitig mit einer massiven Modernisierung des US-Nuklearkommandoapparats. In naher Zukunft sehen Experten angeblich eine gewöhnungsbedürftige KI-Integration die Fähigkeiten von Frühwarn- und Überwachungssystemen zu verbessern, große Datensätze zu durchsuchen, Vorhersagen über feindliches Verhalten zu treffen, den Schutz vor Cyberangriffen zu verbessern und die Kommunikationsinfrastruktur in allen nuklearen Kommandosystemen zu verbessern.

Das Schlechte. Trotz all ihrer Vorteile ist die KI dem Menschen nicht von Natur aus überlegen. KI habe auch erhebliche und einzigartige technische Mängel und Risiken. Jede Integration in nukleare Kommandosysteme müsse sich mit dieser Realität auseinandersetzen und könne, wenn sie unsachgemäß durchgeführt werde, die Wahrscheinlichkeit eines unbeabsichtigten Atomwaffen-Einsatzes erhöhen.

Komplexität führe zu Unfällen. Die Menge an Code, die in KI-Systemen benötigt werde, die für Befehl und Kontrolle verwendet werden, ist immens. Fehler und technische Herausforderungen sind unvermeidlich.

Die „Black Box“-Problematik ist besonders schwierig. Niemand kann richtige Ergebnisse oder gar falsche Ergebnisse von KI in komplexen Situationen nachvollziehen. Wie sollen da die technischen Herausforderungen der KI angegangen werden. KI-Systeme sind etwas unerkennbar, weil sie sich effektiv selbst auf eine Weise programmieren, die kein Mensch vollständig verstehen kann. Diese angeborene Undurchsichtigkeit sei besonders problematisch in sicherheitskritischen Situationen mit kurzen Zeitfenstern, die für eine Nuklearkrise charakteristisch sind, folgert Rautenbach.

Eine technische Herausforderung bestehe auch darin, dass KI „spröde“ sei. Selbst die leistungsstärksten und intelligentesten Systeme können scheitern, wenn sie in unbekanntes Terrain gebracht und gezwungen werden, sich mit Informationen zu konfrontieren, für die sie nicht ausgebildet wurden.

Doktoranden der University of California, Berkeley, stellten beispielsweise fest, dass das KI-System, das sie darauf trainiert hatten, Atari-Videospiele konsequent zu schlagen, auseinanderfiel, wenn sie nur ein oder zwei zufällige Pixel zum Bildschirm hinzufügten. Angesichts der schieren Komplexität des internationalen Bereichs, in dem nukleare Kommandosysteme operieren, könnten diese Anfälligkeiten leicht zu gefährlichen Situationen führen, in denen KI-Systeme „spektakulär ausfallen – oder, was noch gefährlicher ist, falsche Informationen liefern, obwohl sie scheinbar richtig funktionieren“, so Rautenbach.

Eine zweite und etwas kontraintuitive technische Herausforderung besteht darin, dass KI-Systeme mit menschenähnlichen Vorurteilen gebaut werden. Die Algorithmen und Codes, die die Grundlage vermeintlich „objektiver“ autonomer Systeme bilden, werden mit von Menschen bereitgestellten Daten trainiert. Wie wohlmeinend menschliche Programmierer auch sein mögen, es sei unvermeidlich, dass sie menschliche Vorurteile in den Trainingsprozess einbringen.

Beispiel Rekrutierungsalgorithmen

Wenn diese Algorithmen mit den Lebensläufen ehemaliger erfolgreicher Bewerber trainiert wurden, wurde nachweislich die Voreingenommenheit menschlicher Einstellungsausschüsse „gelernt“, die Bewerberinnen zuvor unterschätzt haben.

Das solle nicht heißen, dass KI nicht eingesetzt oder in Sicherheitssysteme integriert werden sollte, so Rautenbach. Jede Technologie hat Fehler, und auch Menschen, die von KI unterstützt oder ersetzt werden, sind keine Musterbeispiele für Perfektion.

Dennoch müssten diese technischen Probleme antizipiert und berücksichtigt werden. „Maßnahmen zur Erhöhung der Sicherheit von KI-Systemen können und müssen ergriffen werden, um diese technischen Probleme zu mindern oder zu verhindern“, so Rautenbach. Die Verpflichtung, den Menschen in die Entscheidungsschleife einzubeziehen, werde eine Rolle bei der Erhöhung der Sicherheit spielen, da das kritische Denken des Menschen ein wichtiges Werkzeug zur Kontrolle der unglaublich mächtigen und intelligenten – aber letztendlich immer noch begrenzten – maschinellen Intelligenz sei.

„Das hässliche“. Leider betrifft die Integration von KI in Nuklearwaffen-Befehlssysteme mehr als nur den maschinellen Aspekt der nuklearen Entscheidungsfindung. Neben diesen technischen Problemen kommen Auswirkungen auf die beteiligten Menschen hinzu, wodurch es weniger effektiv sei, sie auf dem Laufenden zu halten, als es für die Gewährleistung der Sicherheit erforderlich sei.

Ein Schlüsselproblem sei „die Entwicklung von Automatisierungsverzerrungen, durch die Menschen sich zu sehr auf KI verlassen und unbewusst davon ausgehen, dass das System korrekt ist. Diese Verzerrung wurde in mehreren KI-Anwendungen gefunden, darunter medizinische Entscheidungsunterstützungssysteme, Flugsimulatoren, Flugsicherung und sogar in Simulationen, die Schützen dabei helfen sollen, die gefährlichsten feindlichen Ziele zu bestimmen, die sie mit Artillerie angreifen und beschießen können“.

Dies erhöhe nicht nur die Wahrscheinlichkeit, dass technische Mängel unbemerkt bleiben, sondern stelle auch eine unbewusste Vorabdelegation von Befugnissen an „Maschinenintelligenzen“ dar.

Die Gefahren der Automatisierungsverzerrung und der Vordelegierung von Autorität waren bereits in den frühen Stadien der Irak-Invasion 2003 offensichtlich. Zwei von 11 erfolgreichen Abfangaktionen mit automatisierten US-Patriot-Raketensystemen waren Brudermorde (Friendly-Fire-Vorfälle). Das heißt rund 20% haben ganz unpatriotisch die eigenen Leute getroffen. Da Patriot-Systeme darauf ausgelegt waren, taktische ballistische Raketen abzuschießen, verging nur sehr wenig Zeit zwischen der Erkennung und der Entscheidung, um auf die ankommende Bedrohung zu feuern. Dies bedeutete, dass der Prozess weitgehend automatisiert war, mit wenig Möglichkeiten für einen menschlichen Bediener, das Targeting zu beeinflussen. Das System machte die meiste Arbeit erledigen und Bedienende würde nur den letzten Feuerruf machen. Wobei 8 von 10 Raketen ja richtig aus dem Verkehr gezogen werden und unbeabsichtigte „Burdermorde“ auch früheren in Kriegen die Regel waren.

Bei den Brudertötungen identifizierten die „Patrioten“ und ihre Bedienenden fälschlicherweise verbündete Ziele als feindliche Ziele und schossen sofort auf sie, was zum Beispiel den Tod alliierter Piloten verursachte – 2 von 11! Zusätzlich zu den technischen Problemen mit dem System und Problemen im Zusammenhang mit kurzen Entscheidungsfristen fand die Task Force, welche die „Brudermord-Vorfälle“ untersuchte, signifikante Beweise für eine Verzerrung der Automatisierung: Die Bediener der Patriot vertrauten nicht nur ihrem automatisierten System. Sie wurden darauf trainiert, ihm zu vertrauen .

Da ist der Punkt bald erreicht und menschliche Bediener sind nur noch biologische Erweiterungen eines autonomen, praktisch unkontrollierten KI-Systems. Während es ungewiss sei, ob ein Unterschied in der Ausbildung oder Einstellung den Ausgang der Patriot-Brudermorde letztendlich verändert hätte, mache es ein angeborenes Vertrauen in Maschinen viel schwieriger, technische Fehler in KI-Systemen zu verhindern. Automation Bias beeinträchtigt nachweislich das Urteilsvermögen von Menschen in der Schleife.

Diese Probleme könnten etwas gemildert werden, wenn man Menschen darauf trainiere Vorurteile zu erkennen. Ein solches Training sei zwar keine perfekte Lösung, könne jedoch das übermäßige Vertrauen in die Fähigkeiten von KI-Systemen verringern.

Bedürfnis nach Geschwindigkeit?

Trotz der Gefahr von Voreingenommenheit und Vorabdelegation gibt es gute Gründe zu der Annahme, dass Staaten der militärischen KI die Befugnis erteilen, ohne echte menschliche Aufsicht zu handeln. Dies bietet einen verlockenden Vorteil. Es birgt jedoch die Gefahr, den Krieg auf „Maschinengeschwindigkeit“ zu bringen. Wenn der Krieg im Tempo des maschinellen Denkens geführt wird, dann kann die Menschheit mit Lichtgeschwindigkeit ausgelöscht werden. China nennt das „Hyperwar“ oder „Battlefield Singularity“. Es könnten militärische Reaktionen und Entscheidungen in Nanosekunden stattfinden.

Das erinnere an die Befürchtungen des amerikanischen Nuklearstrategie-Experten Thomas Schelling, dass die Prämie für Eile die größte Gefahr für den Frieden sei. Im Bemühen, den Vorteil auf dem Schlachtfeld zu wahren, könnten Staaten in einem wahnsinnigen Sprint nach unten rasen, der die Autorität effektiv an KI-Systeme delegiert. Dies scheint zur Zeit sogar statt zu finden.

Viele einflussreiche Militärs seien nicht dagegen, das menschliche Element weiter aus der Entscheidungsschleife herauszudrängen, so Rautenbach. Während seiner Zeit als Kommandeur von NORAD erklärte General Terrence J. O’Shaughnessy im Jahr 2020, dass „wir wegkommen müssen von … ‚human in the loop‘ oder manchmal ‚the human is the loop‘.“, so Rautenbach.

Intelligenten Maschinen in Extremsituationen die Kontrolle zu überlassen, ist keine Science-Fiction.

Das ballistische Raketenabwehrsystem Aegis

Es wird an Bord von Militärschiffen eingesetzt und ist bereits in der Lage, autonom ohne menschliche Beteiligung zu funktionieren . Dieser Betriebsmodus sei derzeit jedoch militärischen Einsätzen vorbehalten, bei denen Menschen an Bord des Schiffes überwältigt werden könnten – oder was ein Schiffskapitän als ein Tötungs-oder-gekillt-Szenario bezeichnete, das sich im 3. Weltkrieg ereignen könne.

Der amerikanische Politologe Richard K. Betts (2015) warnte: Staaten stolpern oft „aus falscher Wahrnehmung, Fehleinschätzung und Angst zu verlieren, wenn sie nicht zuerst zuschlagen“, in [den Krieg]. Militärische KI, die darauf ausgelegt ist, schnell auf Vorteile zu reagieren, könnte Deeskalationsmöglichkeiten verpassen oder zu schnell funktionieren, als dass menschliche Entscheidungsträger eingreifen und ihre Deeskalationsabsicht signalisieren könnten.

Menschen vollständig aus dem Entscheidungsprozess herauszunehmen, ist extrem. Kein Staat fordere derzeit vollautomatisierte Atomwaffensysteme. Dennoch werden wesentliche Aspekte des Entscheidungsprozesses bzw. seiner unterstützenden Elemente zunehmend automatisiert. Um die Maschinengeschwindigkeit voll auszunutzen werden Staaten Menschen an wichtigen Kreuzungen gezielt aus der Schleife entfernen, wenn wir das nicht verhindern!

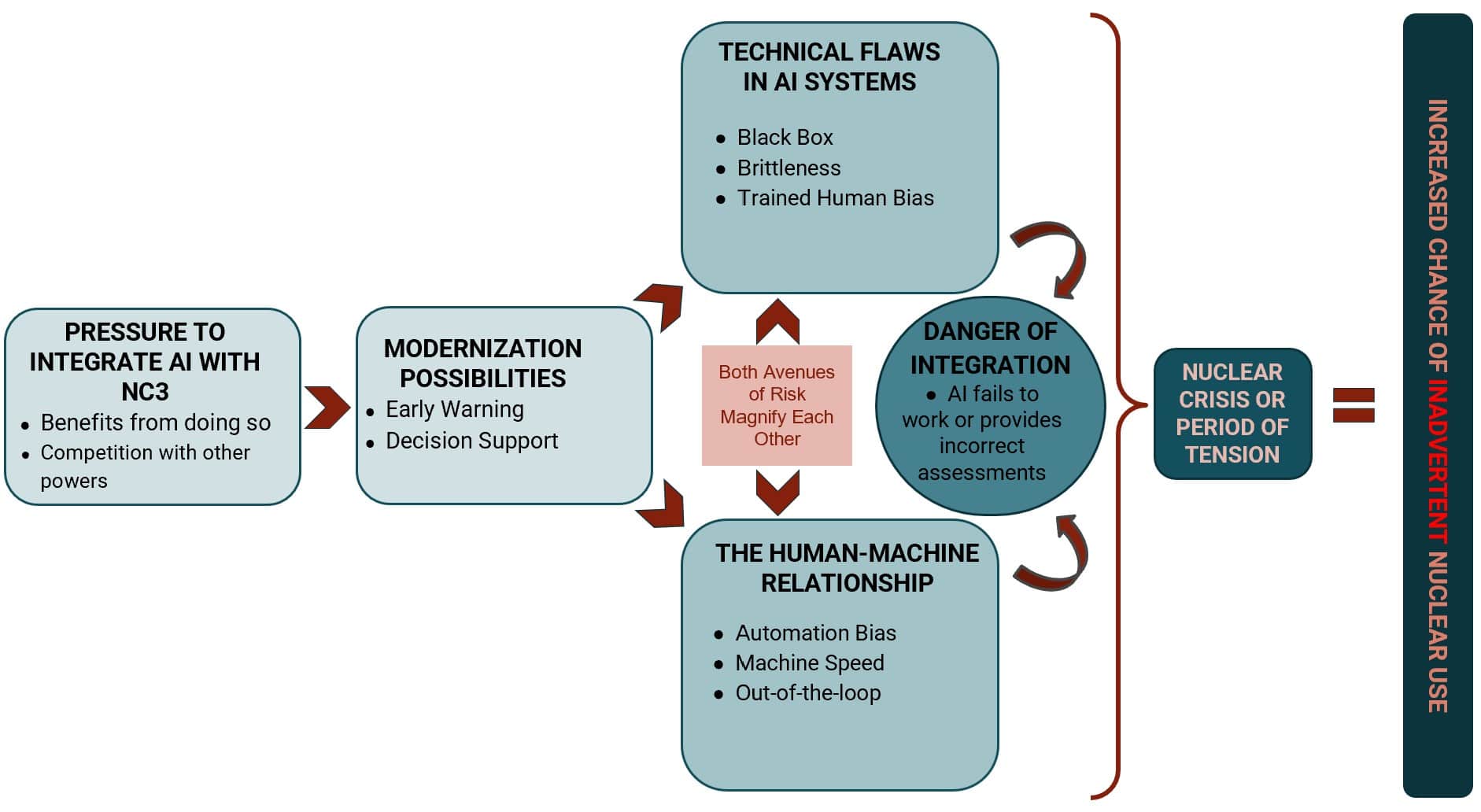

Während Menschen alles andere als perfekt sind, schafft die Unerkennbarkeit von KI-Systemen gepaart mit der impliziten Annahme ihrer Überlegenheit ein gefährliches Umfeld. Rautenbach zeigt, wie in der folgenden Grafik dargestellt, die Integration von KI in nukleare Befehls-, Kontroll- und Kommunikationssysteme (NC3) die könnte Wahrscheinlichkeit eines unbeabsichtigten Einsatzes von Atomwaffen erhöhen.

Um diese Risiken zu mindern, könnte es Staaten wie den Vereinigten Staaten und dem Vereinigten Königreich – aus ihrer Position der Stärke heraus – leicht fallen, vollautomatisierte Nuklearsysteme zu verurteilen. Das Gleiche gilt jedoch nicht unbedingt für andere Atommächte.

Ein junger Atomwaffenstaat wie Nord-Korea, der von immens mächtigen Feinden umgeben ist, könnte vollautomatisierte Systeme als seine einzige Möglichkeit für eine wirksame Abschreckung gegen die Aussicht auf einen blitzschnellen Erstschlag ansehen.

Selbst für derzeit sichere Staaten könnten nun aufkommende Trägersysteme wie fraktionierte orbitale Bombardierungssysteme die Frühwarnung insgesamt umgehen und den bereits kritisch kurzen Zeitrahmen für die existenzielle Entscheidungsfindung erheblich verkürzen. Mit zunehmender tatsächlicher und wahrgenommener Kriegsgeschwindigkeit stelle sich die Frage, wie James Johnson, der Autor von Artificial Intelligence and the Future of Warfare, kürzlich formulierte, vielleicht sei es weniger die Frage, ob nuklear bewaffnete Staaten KI-Technologie in ihr Atomwaffen-Regime übernehmen werden, sondern eher:

- von wem?

- wann?

- in welchem Umfang ?

Glaubwürdige Verpflichtungen, Menschen auf dem Laufenden zu halten, wären wichtige Signalinstrumente und bieten eine Möglichkeit, die technischen Probleme von KI-Systemen zu bewältigen. Wobei solange Atomwaffen die Menschheit bedrohen gibt es keine nachhaltige Sicherheit vor ihnen. „Angesichts der sich verändernden Mensch-Maschine-Beziehungen und der Auswirkungen von KI auf die menschliche Entscheidungsfindung reichen diese Verpflichtungen jedoch nicht aus“, so Rautenbach.

Welche Änderungen in der Anarchie der Atomwaffenstaaten sind sind dringen und existenziell?

Änderungen der nuklearen Doktrin, Politik und Ausbildung werden erforderlich sein, um den unbeabsichtigten Einsatz von Atomwaffen im Zeitalter intelligenter Maschinen zu verhindern. Selbstverständlich erfordert es sofort auch praktikable technischen Lösungen und strenge kooperative Überprüfungen.

Anmerkung: Dieser Artikel ist eine Überarbeitung eines Papiers, das Rautenberg auf der International Student/Young Pugwash (ISYP) Third Nuclear Age Conference im November 2022 vorgestellt wurde. Ausgewählte Teilnehmer hatten die Möglichkeit, ihre Arbeit zur Veröffentlichung durch das Bulletin einzureichen, das eines von ISYPs war Partner für die Konferenz.

Gemeinsam machen wir die Welt sicherer.

Das Bulletin erhebt Expertenstimmen über den Lärm. Aber als unabhängige, gemeinnützige Medienorganisation sind unsere Aktivitäten auf die Unterstützung von Lesern wie Ihnen angewiesen. Helfen Sie uns, weiterhin Qualitätsjournalismus zu liefern, der Führungskräfte zur Rechenschaft zieht. Ihre Unterstützung unserer Arbeit auf allen Ebenen ist wichtig . Im Gegenzug versprechen wir, dass unsere Berichterstattung verständlich, einflussreich, wachsam, lösungsorientiert und fair sein wird. Zusammen können wir einen Unterschied machen.Machen Sie jetzt Ihr Geschenk

Schlüsselwörter: Automation Bias , Humans in the Loop , Nuclear Command

Topics: Artificial Intelligence , Nuclear Weapons , Opinion , Voices of Tomorrow